Markov-prosesse is in 1907 deur wetenskaplikes ontwikkel. Vooraanstaande wiskundiges van daardie tyd het hierdie teorie ontwikkel, sommige van hulle is nog besig om dit te verbeter. Hierdie stelsel strek ook na ander wetenskaplike velde. Praktiese Markov-kettings word in verskeie gebiede gebruik waar 'n persoon in 'n toestand van verwagting moet arriveer. Maar om die stelsel duidelik te verstaan, moet jy kennis dra van die bepalings en bepalings. Willekeurigheid word beskou as die hooffaktor wat die Markov-proses bepaal. Dit is weliswaar nie soortgelyk aan die konsep van onsekerheid nie. Dit het sekere voorwaardes en veranderlikes.

Kenmerke van die ewekansigheidsfaktor

Hierdie toestand is onderhewig aan statiese stabiliteit, meer presies, sy reëlmatighede, wat nie in ag geneem word in geval van onsekerheid nie. Op sy beurt laat hierdie kriterium die gebruik van wiskundige metodes in die teorie van Markov-prosesse toe, soos opgemerk deur 'n wetenskaplike wat die dinamika van waarskynlikhede bestudeer het. Die werk wat hy geskep het, het direk oor hierdie veranderlikes gehandel. Op sy beurt het die bestudeerde en ontwikkelde ewekansige proses, wat die konsepte van staat en hetoorgang, sowel as gebruik in stogastiese en wiskundige probleme, terwyl dit hierdie modelle toelaat om te funksioneer. Dit bied onder meer 'n geleentheid om ander belangrike toegepaste teoretiese en praktiese wetenskappe te verbeter:

- diffusie-teorie;

- toue-teorie;

- teorie van betroubaarheid en ander dinge;

- chemie;

- fisika;

- meganika.

Noodsaaklike kenmerke van 'n onbeplande faktor

Hierdie Markov-proses word gedryf deur 'n ewekansige funksie, dit wil sê, enige waarde van die argument word beskou as 'n gegewe waarde of een wat 'n vooraf-voorbereide vorm aanneem. Voorbeelde is:

- ossillasies in die stroombaan;

- bewegende spoed;

- oppervlakgrofheid in 'n gegewe area.

Daar word ook algemeen geglo dat tyd 'n feit is van 'n ewekansige funksie, dit wil sê dat indeksering plaasvind. 'n Klassifikasie het die vorm van 'n toestand en 'n argument. Hierdie proses kan met diskrete sowel as deurlopende toestande of tyd wees. Boonop is die gevalle anders: alles gebeur óf in een óf in 'n ander vorm, of gelyktydig.

Gedetailleerde ontleding van die konsep van willekeurigheid

Dit was nogal moeilik om 'n wiskundige model met die nodige prestasie-aanwysers in 'n duidelik analitiese vorm te bou. In die toekoms het dit moontlik geword om hierdie taak te verwesenlik, omdat 'n willekeurige Markov-proses ontstaan het. Deur hierdie konsep in detail te ontleed, is dit nodig om 'n sekere stelling af te lei. 'n Markov-proses is 'n fisiese sisteem wat sy verander hetposisie en toestand wat nie vooraf geprogrammeer is nie. Dit blyk dus dat 'n lukrake proses daarin plaasvind. Byvoorbeeld: 'n ruimtebaan en 'n skip wat daarin gelanseer word. Die resultaat is slegs behaal as gevolg van 'n paar onakkuraathede en aanpassings, waarsonder die gespesifiseerde modus nie geïmplementeer word nie. Die meeste van die deurlopende prosesse is inherent aan willekeurigheid, onsekerheid.

Op meriete, byna enige opsie wat oorweeg kan word, sal aan hierdie faktor onderhewig wees. 'n Vliegtuig, 'n tegniese toestel, 'n eetkamer, 'n horlosie - dit alles is onderhewig aan lukrake veranderinge. Boonop is hierdie funksie inherent aan enige voortdurende proses in die werklike wêreld. Solank dit egter nie van toepassing is op individueel ingestelde parameters nie, word die steurings wat voorkom as deterministies beskou.

Die konsep van 'n Markov-stogastiese proses

Deur enige tegniese of meganiese toestel te ontwerp, dwing toestel die skepper om verskeie faktore in ag te neem, veral onsekerhede. Die berekening van ewekansige skommelinge en versteurings ontstaan op die oomblik van persoonlike belangstelling, byvoorbeeld wanneer 'n outovlieënier geïmplementeer word. Sommige van die prosesse wat in wetenskappe soos fisika en meganika bestudeer word, is.

Maar om aandag aan hulle te gee en streng navorsing te doen, moet begin op die oomblik wanneer dit direk nodig is. 'n Markov ewekansige proses het die volgende definisie: die waarskynlikheidskenmerk van die toekomstige vorm hang af van die toestand waarin dit op 'n gegewe tydstip is, en het niks te doen met hoe die sisteem gelyk het nie. So gegeedie konsep dui aan dat die uitkoms voorspel kan word, met inagneming van slegs die waarskynlikheid en vergeet van die agtergrond.

Gedetailleerde verduideliking van die konsep

Op die oomblik is die stelsel in 'n sekere toestand, dit beweeg en verander, dit is basies onmoontlik om te voorspel wat volgende gaan gebeur. Maar, gegewe die waarskynlikheid, kan ons sê dat die proses in 'n sekere vorm voltooi sal word of die vorige een sal behou. Dit wil sê, die toekoms ontstaan uit die hede, en vergeet van die verlede. Wanneer 'n stelsel of proses 'n nuwe toestand betree, word die geskiedenis gewoonlik weggelaat. Waarskynlikheid speel 'n belangrike rol in Markov-prosesse.

Byvoorbeeld, die Geiger-teller wys die aantal deeltjies, wat afhang van 'n sekere aanwyser, en nie van die presiese oomblik wat dit gekom het nie. Hier is die hoofkriterium bogenoemde. In praktiese toepassing kan nie net Markov-prosesse oorweeg word nie, maar ook soortgelyke, byvoorbeeld: vliegtuie neem deel aan die stryd van die stelsel, wat elkeen met 'n sekere kleur aangedui word. In hierdie geval is die hoofkriterium weer die waarskynlikheid. Op watter punt die oorwig in getalle sal voorkom, en vir watter kleur, is onbekend. Dit wil sê, hierdie faktor hang af van die toestand van die stelsel, en nie van die volgorde van vliegtuigsterftes nie.

Struktuuranalise van prosesse

'n Markov-proses is enige toestand van 'n stelsel sonder 'n waarskynlike gevolg en sonder inagneming van geskiedenis. Dit wil sê as jy die toekoms by die hede insluit en die verlede weglaat. Oorversadiging van hierdie tyd met voorgeskiedenis sal lei tot multidimensionaliteit enkomplekse konstruksies van stroombane sal vertoon. Daarom is dit beter om hierdie stelsels te bestudeer met eenvoudige stroombane met minimale numeriese parameters. Gevolglik word hierdie veranderlikes as bepalend beskou en deur sommige faktore gekondisioneer.

'n Voorbeeld van Markov-prosesse: 'n werkende tegniese toestel wat op hierdie oomblik in 'n goeie toestand is. In hierdie toedrag van sake, wat van belang is, is die waarskynlikheid dat die toestel vir 'n lang tydperk sal funksioneer. Maar as ons die toerusting as ontfout beskou, sal hierdie opsie nie meer deel uitmaak van die proses wat oorweeg word nie, aangesien daar geen inligting is oor hoe lank die toestel voorheen gewerk het en of herstelwerk gedoen is nie. As hierdie twee tydsveranderlikes egter aangevul en by die stelsel ingesluit word, kan die toestand daarvan aan Markov toegeskryf word.

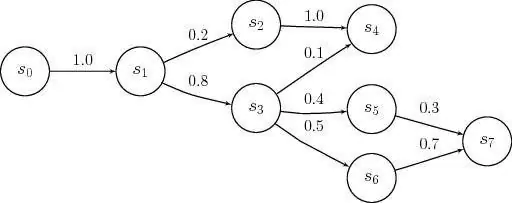

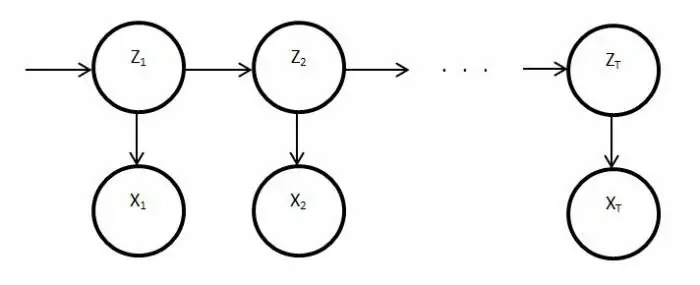

Beskrywing van diskrete toestand en kontinuïteit van tyd

Markov-prosesmodelle word toegepas op die oomblik wanneer dit nodig is om die voorgeskiedenis te verwaarloos. Vir navorsing in die praktyk word diskrete, kontinue toestande meestal teëgekom. Voorbeelde van so 'n situasie is: die struktuur van die toerusting sluit nodusse in wat tydens werksure kan misluk, en dit gebeur as 'n onbeplande, lukrake aksie. As gevolg hiervan, die toestand van die stelsel ondergaan herstel van die een of die ander element, op hierdie oomblik sal een van hulle gesond wees of beide van hulle sal ontfout word, of andersom, hulle is volledig aangepas.

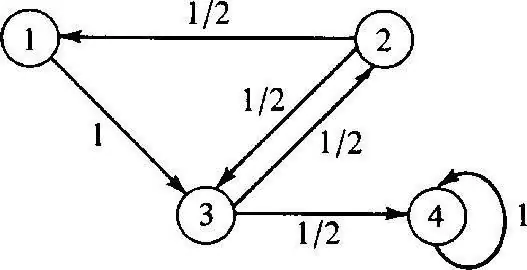

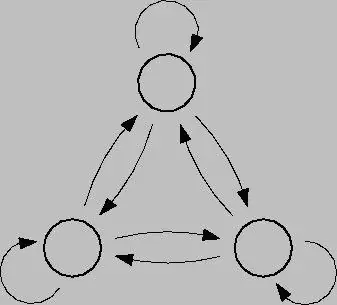

Die diskrete Markov-proses is gebaseer op waarskynlikheidsteorie en is ookoorgang van die stelsel van een toestand na 'n ander. Boonop kom hierdie faktor onmiddellik voor, selfs as toevallige onklaarrakings en herstelwerk plaasvind. Om so 'n proses te ontleed, is dit beter om toestandsgrafieke te gebruik, dit wil sê meetkundige diagramme. Stelseltoestande word in hierdie geval deur verskeie vorms aangedui: driehoeke, reghoeke, kolletjies, pyle.

Modellering van hierdie proses

Diskrete-toestand Markov-prosesse is moontlike wysigings van stelsels as gevolg van 'n oombliklike oorgang, en wat genommer kan word. Byvoorbeeld, jy kan 'n toestandsgrafiek bou van pyle vir nodusse, waar elkeen die pad van verskillend gerigte mislukkingsfaktore, bedryfstoestand, ens sal aandui. In die toekoms kan enige vrae ontstaan: soos die feit dat nie alle meetkundige elemente wys nie in die regte rigting, want in die proses kan elke nodus agteruitgaan. Wanneer jy werk, is dit belangrik om sluitings te oorweeg.

Deurlopende-tyd Markov-proses vind plaas wanneer die data nie vooraf vasgestel is nie, dit gebeur lukraak. Oorgange was nie voorheen beplan nie en vind te eniger tyd in spronge plaas. In hierdie geval word die hoofrol weer deur waarskynlikheid gespeel. As die huidige situasie egter een van die bogenoemde is, sal 'n wiskundige model vereis word om dit te beskryf, maar dit is belangrik om die teorie van moontlikheid te verstaan.

Waarskynlikheidsteorieë

Hierdie teorieë beskou waarskynlikheid, met kenmerkende kenmerke sooswillekeurige volgorde, beweging en faktore, wiskundige probleme, nie deterministies nie, wat nou en dan seker is. 'n Gekontroleerde Markov-proses het en is gebaseer op 'n geleentheidsfaktor. Boonop is hierdie stelsel in staat om onmiddellik na enige toestand oor te skakel in verskillende toestande en tydintervalle.

Om hierdie teorie in die praktyk toe te pas, is dit nodig om 'n belangrike kennis van waarskynlikheid en die toepassing daarvan te hê. In die meeste gevalle is 'n mens in 'n toestand van verwagting, wat in 'n algemene sin die betrokke teorie is.

Voorbeelde van waarskynlikheidsteorie

Voorbeelde van Markov-prosesse in hierdie situasie kan wees:

- kafee;

- kaartjiekantore;

- herstelwinkels;

- stasies vir verskeie doeleindes, ens.

In die reël kry mense elke dag te doen met hierdie stelsel, vandag word dit toustaan genoem. By fasiliteite waar so 'n diens teenwoordig is, is dit moontlik om verskeie versoeke te eis, wat in die proses bevredig word.

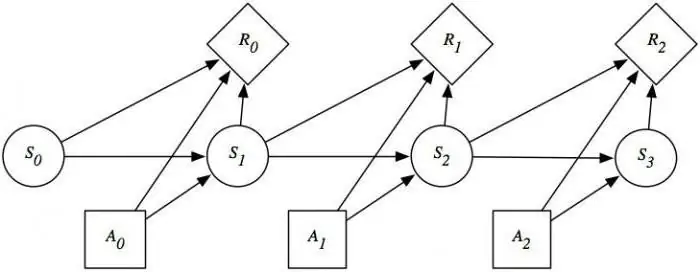

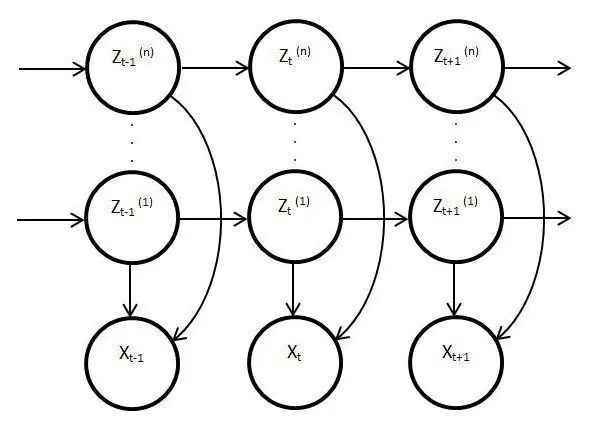

Versteekte prosesmodelle

Sulke modelle is staties en kopieer die werk van die oorspronklike proses. In hierdie geval is die hoofkenmerk die funksie om onbekende parameters te monitor wat ontrafel moet word. As gevolg hiervan kan hierdie elemente gebruik word in analise, praktyk of om verskeie voorwerpe te herken. Gewone Markov-prosesse is gebaseer op sigbare oorgange en op waarskynlikheid, slegs onbekendes word in die latente model waargeneemveranderlikes wat deur staat geraak word.

Noodsaaklike openbaarmaking van versteekte Markov-modelle

Dit het ook 'n waarskynlikheidsverdeling onder ander waardes, gevolglik sal die navorser 'n reeks karakters en toestande sien. Elke aksie het 'n waarskynlikheidsverdeling onder ander waardes, dus verskaf die latente model inligting oor die gegenereerde opeenvolgende toestande. Die eerste aantekeninge en verwysings daarna het in die laat sestigerjare van die vorige eeu verskyn.

Toe is hulle gebruik vir spraakherkenning en as ontleders van biologiese data. Daarbenewens het latente modelle versprei in skrif, bewegings, rekenaarwetenskap. Hierdie elemente boots ook die werk van die hoofproses na en bly staties, maar ten spyte hiervan is daar baie meer kenmerkende kenmerke. Hierdie feit het veral betrekking op direkte waarneming en reeksgenerering.

Stasionary Markov-proses

Hierdie toestand bestaan vir 'n homogene oorgangsfunksie, sowel as vir 'n stilstaande verspreiding, wat as die hoof- en, per definisie, 'n ewekansige aksie beskou word. Die faseruimte vir hierdie proses is 'n eindige versameling, maar in hierdie toedrag van sake bestaan die aanvanklike differensiasie altyd. Oorgangswaarskynlikhede in hierdie proses word oorweeg onder tydstoestande of bykomende elemente.

Gedetailleerde studie van Markov-modelle en prosesse onthul die kwessie van die bevrediging van die balans in verskeie lewensareasen aktiwiteite van die samelewing. Aangesien hierdie bedryf wetenskap en massadienste raak, kan die situasie reggestel word deur die uitkoms van enige gebeure of aksies van dieselfde foutiewe horlosies of toerusting te ontleed en te voorspel. Om die vermoëns van die Markov-proses ten volle te gebruik, is dit die moeite werd om dit in detail te verstaan. Hierdie toestel het immers 'n wye toepassing gevind, nie net in die wetenskap nie, maar ook in speletjies. Hierdie stelsel in sy suiwer vorm word gewoonlik nie oorweeg nie, en as dit gebruik word, dan slegs op grond van bogenoemde modelle en skemas.